近日,哈工大(深圳)HLT研究组刷新了Allen AI平台的常识推理问答ProtoQA任务榜单,该技术方案两次登顶,为掩码语言模型在生成式常识问答上的应用提供一种可行的解决思路,从而为诸如人机对话场景提供很多技术支持,使得对话更为智能,帮助客服机器人、语音助手等更好地理解人类指令。

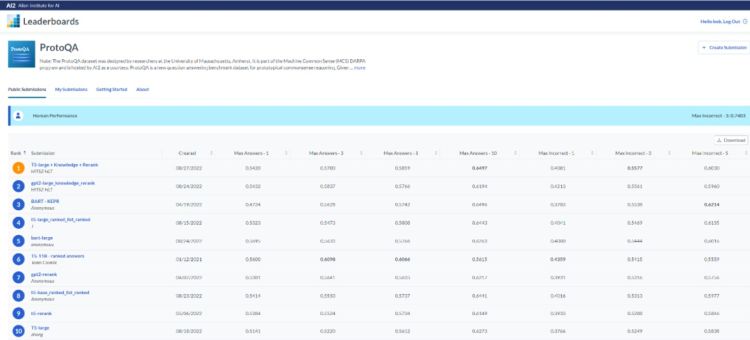

ProtoQA 榜单

ProtoQA榜单由UMass Amherst提出,目标是测试人工智能系统的常识推理能力。常识是人工智能研究的重要内容,机器常识或机器对开放世界的理解和推理能力一直被认为是人工智能和自然语言理解的重要组成部分。常识问答则是机器推理上的一个重要的应用方向,目的是帮助计算机通过已有的知识推理判断未见过的输入信息,从而使计算机更自然地理解人们的表达。

长时间以来,许多研究致力于推进这一领域的发展,特别是近年来采用预训练语言模型、知识图谱、提示学习等新技术的方法得到广泛研究。尽管一些模型在选择式的常识问答数据集上超过人类水平,但是在没有预先给定选项的场景下,如何基于常识和背景知识进行生成式的推理以获得答案仍旧是一个巨大的挑战。

ProtoQA是开放场景下基于常识推理的生成式问答基准数据集。例如:说出人们在离开家上班之前通常会做的事情。相较于众多的单选题式常识问答数据集,ProtoQA的难点在于:该数据集没有提供候选答案选项,需要模型自行生成答案;每个问题可以有多个合乎常识的答案,但是越典型(普遍)的答案得分越高。因此,需要模型评估和生成更典型的答案。

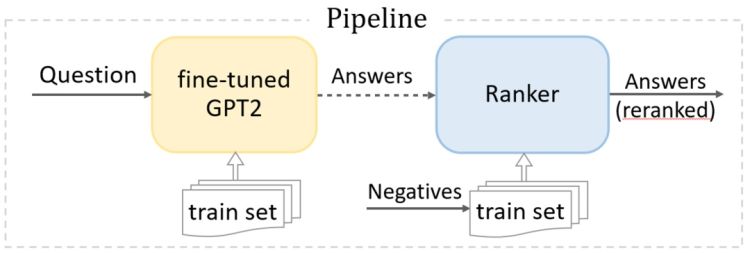

掩码模型重排序流水线框架

哈工大(深圳)HLT研究组于2022年8月24日获得AI2 Leaderboards中ProtoQA榜首。而后另一模型再次登顶,目前霸榜前两名。指导老师、哈工大(深圳)徐睿峰教授表示,团队该研究的核心思想是先利用掩码语言模型计算采样结果的典型程度,再借助WordNet根据三种不同的策略生成负样本,并通过KL散度衡量预测分布和目标分布间的差异,最后反馈给生成式语言模型降序输出。在DeBERTa、RoBERTa、BERT、GPT-2,BART 和 T5多个模型上的结果证明了该方法计算快速且效果稳定。

哈工大(深圳)HLT研究组表示,该模型优异的性能表现有力证明了,掩码语言模型和自回归语言模型的结合在生成式问答任务上的强大优势,以及机器阅读理解模型可以通过构建合适的预训练+重排序方式,实现超越复杂专业模型的表现。此外,除了重排序还可以通过强化学习的方式直接增强自回归语言模型的建模能力。

谈到常识问答目前的发展和趋势,哈工大(深圳)HLT团队表示,未来的常识问答会更注重几个方面的研究:首先是开放式问答,由机器自行从库中搜索并收集信息进行问答。其次通过对文本进行多步推理,从多条相关文本中获取答案的研究。最后是因果推理,即让模型像人类通过对相关数据分析进行因果发现,提取因果关系用于常识问答。

哈工大(深圳)常识推理任务参与的同学有罗璇、范创、张义策、黄仕爵、梁斌等。指导教师为徐睿峰教授和秦兵教授。相关研究工作近日已获自然语言处理国际顶级会议 EMNLP 2022 录用。

审读:孙世建