【哈工大(深圳)宣】(孔笑宇/文、图)近日,哈工大(深圳)计算机科学与技术学院何震宇教授团队的论文《Audio2Motion: Generating Diverse Gestures from Speech with Conditional Variational Autoencoders》(以下简称“Audio2Motion”)与 《Saliency-Associated Object Tracking》(以下简称“SAOT”)被计算机视觉顶级会议(International Conference on Computer Vision 2021(ICCV 2021)录用。

ICCV会议是世界顶级的计算机视觉学术会议,该会议的录取论文代表了计算机视觉领域的最高科技水平,2021年论文录取率为25.9%。Audio2Motion论文由2019级博士研究生李晶担任第一作者,何震宇教授为通讯作者,哈工大(深圳)为通讯单位。SAOT论文由2018级博士研究生周子坤担任第一作者,裴文杰助理教授担任第二作者,何震宇教授与裴文杰助理教授为共同通讯作者,哈工大(深圳)为通讯单位。

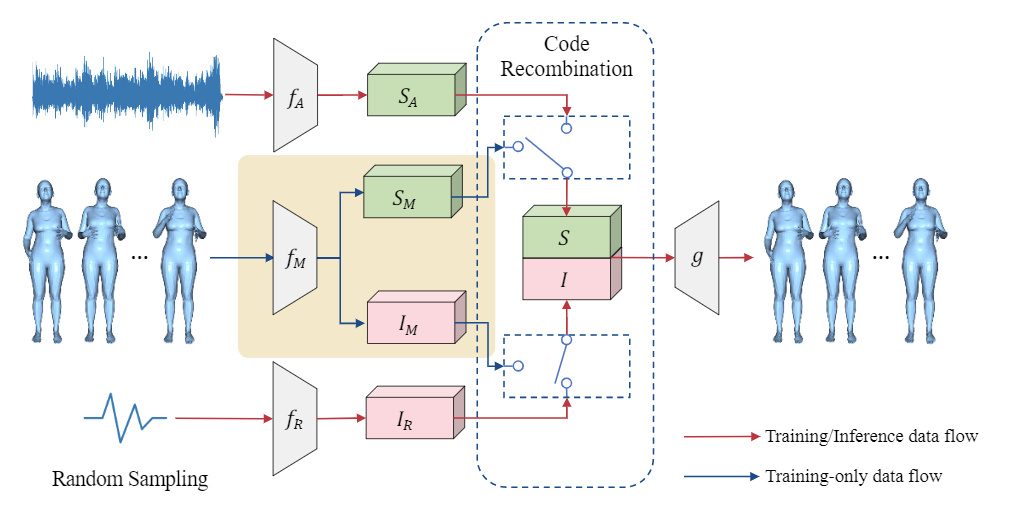

Audio2Motion算法能够从同一段音频中生成丰富多样的动作,大大降低虚拟现实应用的开发成本,使对话情境下的虚拟人物更加逼真。Audio2Motion论文指出,即使同一个人在说相同语言的时候,身体也有可能做出完全不同的动作。该论文发现已有语音驱动动作生成模型没有考虑语音与动作一对多映射的本质,导致现有模型容易生成平均动作(averaged motion),从而设计了一套虚拟人动作生成算法Audio2Motion。该算法对语音与动作进行一对多映射建模,在模型推理时能够为同一段音频生成多种不同的动作。为了对语音-动作的一对多映射进行建模,该模型把动作的特征解耦为动作音频共享特征(shared feature)与动作特有特征(motion-specific feature)。推理时,模型从音频中提取共享特征,并采样不同的动作特有特征生成不同的动作。训练过程中,提供一对音频与动作,模型从音频中提取共享特征,从动作中提取共享特征与动作特有特征,对特征重新组合后重建输入的动作。实验结果表明该算法生成的动作质量明显超过本领域现有方法,该算法有望推动虚拟客服等领域的技术进步。

图1.Audio2Motion网络结构

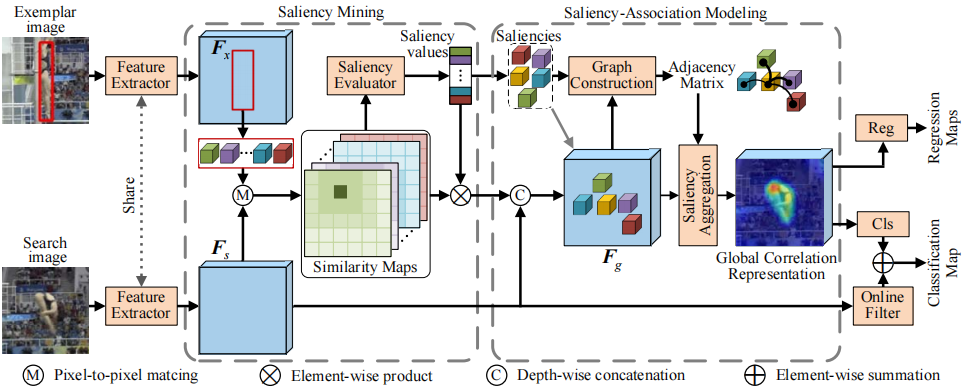

当前基于分块思想的追踪算法采用的策略是将目标均匀等分然后并行追踪每一个局部块,这种策略的一个潜在缺点是并非所有的局部块都包含有效信息,而某些不具备区分性的局部块甚至可能对追踪带来反作用。针对这个问题,SAOT论文提出显著点关联追踪器(Saliency-Associated Object Tracking,SAOT),使用具有区分性的显著局部块来进行追踪。SAOT首先使用显著点挖掘模块(Saliency Mining),找出目标具有区分性的局部显著点,然后使用显著点关联模型(Saliency-Association Modeling)将所有显著点关联起来以学习样本与搜索目标之间的有效关联特征以完成最后的追踪工作。实验结果表明SAOT算法超过了现有目标跟踪方法,拥有更高的追踪精度以及应对真实场景变化的鲁棒性,有望在自动驾驶、精准制导、视频监控等领域广泛应用。(编辑 谢梁晖)

图2. SAOT网络结构